El uso de inteligencia artificial (IA) en la música empezó a cobrar relevancia en los últimos meses a partir de una serie de experimentos que circularon a escala viral en las redes. La proliferación de versiones deepfake (acrónimo integrado por las palabras fake, falsificación, y deep learning, aprendizaje profundo) de artistas populares, rejuvenecimientos vocales y colaboraciones y feats que nunca existieron son tan sólo el mascarón de proa de una herramienta que avanza rápidamente y obliga a replantear las reglas del juego para todos los actores involucrados.

Si cada nuevo descubrimiento o progreso tecnológico forzó en el pasado a repensar metodologías de consumo y difusión, la proliferación del empleo de IA va un paso más allá con una serie de interrogantes que ya no tienen que ver con la titularidad de los derechos de la obra en sí sino de la emulación de una voz humana creada a través de un software intuitivo. De igual manera, aparece otra zona gris por resolver: ¿a quién pertenece la autoría de canciones gestadas artificialmente por agentes autónomos, que ya no sólo emulan los procesos de razonamiento humano, sino también las abstracciones propias de la creatividad?

Empecemos por decir que la inteligencia artificial es un conjunto de sistemas informáticos y combinaciones de algoritmos alineados con la finalidad de que las máquinas repliquen la inteligencia humana. A mayor información recopilada, más preciso es el resultado final: a través de una combinación de disciplinas entre las que están el machine y el deep learning, las redes neuronales artificiales, la robótica y los sistemas de reconocimiento de voz, las IA son capaces de replicar el esfuerzo humano y también de borrar la frontera entre lo real y lo ficcional.

Con sólo un par de tutoriales a cuestas, un usuario puede aislar y reproducir la voz de cualquier artista, lo que también abre una discusión similar a la que generó la proliferación del sampling entre finales de los 80 y principios de los 90, pero con implicancias más cercanas a las de la usurpación de identidad.

“La IA nos dio la oportunidad de colaborar de una manera extrañísima con uno de nuestros artistas favoritos”, le cuenta a ROLLING STONE Jon Claire, baterista de Breezer, la banda responsable de Aisis, un proyecto en el que grabaron sus temas utilizando la voz de… Liam Gallagher. El grupo nació en 2021 y, a pesar de haber alcanzado una difusión aceptable, tuvo una vida fugaz antes de que las obligaciones extramusicales de sus integrantes lo pusieran en stand by. Con Oasis como clara referencia artística, la banda entró al estudio para inmortalizar su repertorio y la tecnología hizo posible que el resultado se volviese viral y los obligase a volver al ruedo de manera inesperada, con un regreso a los escenarios que se concretará este sábado 10 de junio en el histórico 100 Club londinense.

Si bien en YouTube (donde acumuló más de 400.000 reproducciones en menos de un mes) The Lost Tapes, el álbum de Aisis, incluye un disclaimer en el que se lo define como “un álbum conceptual de una realidad alternativa donde la formación de la banda del 95 al 97 continuó escribiendo música”, para el guitarrista Chris Woodgates nunca hubo una intención explícita de hacer pasar el material como si hubiese sido creado por los hermanos Gallagher.

“Son nuestras canciones y estamos orgullosos de ellas. Fue más una manera de hacer música, donde podés tomar una influencia y colaborar con tu artista favorito, o reimaginar algo que en realidad nunca existió”, explica. “Nunca estuvo destinado a viralizarse ni nada por el estilo. El hecho de que a mucha gente le gustara es increíble y creo que tiene que ver con que desde el punto de vista creativo es algo bastante novedoso”, completa.

Con el material ya armado, el vocalista, compositor y productor del grupo, Bobby Geraghty, propuso darles a las canciones una vuelta de tuerca. Buceando en Google Colab, se topó con so-vits-svc-fork, una interfaz de conversión de voz, y se lanzó a entrenar un modelo de IA sin tener ningún conocimiento previo en la materia. “Me tomó alrededor de dieciséis horas en las que empecé a ‘alimentar’ la IA con videos a capela de Liam que encontré en YouTube. A medida que los iba escuchando, el sistema asimilaba sus frecuencias”, explica Geraghty.

Lo sorprendente no es sólo el resultado final, que efectivamente emula la voz de Gallagher, sino que fue llevado a cabo sin que ninguno de los involucrados tuviese ningún tipo de conocimiento previo en la materia. “No sé cómo funciona. Sé que [la interfaz] lo escucha y construye su modelo a partir de cómo cree que tiene que sonar. Solamente vi un par de tutoriales y pensé que podía hacerlo, eso fue todo”, dice.

El álbum de Breezer (o Aisis, para ser más precisos) comenzó a circular en grupos de Reddit de fans de Oasis y no tardó en volverse un fenómeno viral, con camadas de seguidores celebrando que sus canciones eran lo más cercano en mucho tiempo a una vuelta al ruedo de la banda a catorce años de su separación. El éxito de The Lost Tapes explica también uno de los fenómenos más enrevesados que acarrea el uso de la inteligencia artificial aplicada a la música: la nostalgia por algo que no ocurrió; una suerte de recuerdo distópico, ya que el público tiene plena conciencia de que no está escuchando algo que realmente haya existido.

En su canal de YouTube, el productor Rick Beato lo ejemplificó con “Winter’s Cold”, un deepfake bajo el nombre de DrakeAI: aun sabiendo que no se trata de una canción real del rapero canadiense, el tema tiene más de un millón de vistas. Para Beato, una vez que logren desarrollar sus propios sistemas y tengan una legislación a favor, los sellos se van a liberar de los artistas y crearán música artificial para un público indiferente. Hasta el propio Liam Gallagher elogió el trabajo realizado por Breezer. “No pude escuchar el disco, solamente una canción. Me gustó, es mejor que todo lo demás que anda por ahí”, dijo el bocón manchesteriano en un intercambio tuitero con un seguidor.

Not the album heard a tune it’s better than all the other snizzle out there

— Liam Gallagher (@liamgallagher) April 19, 2023

El uso de voces mediante IA abrió ese mismo debate: ¿se está infringiendo algún tipo de copyright si lo que se emula es una textura vocal? A finales de abril, el tiktoker Ghostwriter977 publicó “Heart on my Sleeve”, una falsa colaboración entre Drake y The Weeknd que fue dada de baja de la red social a los pocos días. Cuando el tema llegó a YouTube, la canción fue eliminada, pero por una presunta infracción a los derechos de autor de Universal Music Group, un detalle al menos llamativo si se considera que el tema era una composición original de su creador.

“El germen del problema ético y moral está en el uso de la voz de otra persona. Los temas de Gardel son de dominio público, ¿y su voz también?”, se pregunta Tweety González, no sin augurar una catarata de nuevos tangos con la voz del Zorzal Criollo emulada digitalmente. La artista experimental Holly Herndon creó Holly+, una web en la que es posible cargar cualquier tipo de audio polifónico y descargarlo con la voz de Herndon sin importar el idioma y de manera gratuita. En el otro extremo, Grimes anunció un sistema similar, pero con una única condición: compartir el 50 por ciento de las regalías del resultado final.

“El derecho llega mucho más tarde que el avance tecnológico. Eso te obliga a tener que replantear las reglas de juego. Cuando ya terminaste de replantearlas, tenés un desafío mil veces más grande. Con la inteligencia artificial, los desafíos de derecho de autor crecieron exponencialmente”, explica el músico y productor Lautaro Barceló, que se encuentra además a mitad de camino en la carrera de Ingeniería de IA.

“Contrario a lo que una persona podría pensar, de que lo que nunca nos podrían robar es la creatividad, estos sistemas sí son creativos. Para las decisiones que toman son probabilísticos, no deterministas. No te van a dar siempre la misma respuesta a algo, vos le podés hacer cien veces la misma pregunta y te responden cien cosas distintas”, completa.

Aunque tiene sus reservas sobre su uso e implementaciones, Tweety también valora los aspectos positivos de este tipo de procesos. “Sigo pensando que lo importante es lo que le das de comer a la herramienta. Tu cultura pop va a ser clave, tu entorno también. No es lo mismo que yo me ponga a jugar con Dall-E para hacer tapas para mi sello, que un tipo que estudió Bellas Artes; él le va a sacar más jugo porque va a saber pedirle más. De la misma manera, si yo me pongo a hacer música con inteligencia artificial, me va a salir mejor que alguien que en su vida hizo música”, analiza.

Y, si bien hace ya algunos años que la IA se utiliza para generar música funcional de aeropuertos o las pistas gratuitas que ofrece YouTube para insertar en videos creados por usuarios, a Tweety la proliferación de este modelo le dispara varios interrogantes. “Es música genérica sin ningún tipo de magia. Lo que pasa es que hay un tipo de público que se conforma con esa música genérica, y ese es mi gran temor: las generaciones nuevas y el daño que les puede hacer. Los que conocemos la música real tenemos cómo comparar, pero va a llegar un momento donde habrá chicos que no van a poder hacer esa comparación, les va a dar lo mismo. Ya empieza a pasar: vas a un show y cada vez hay más música grabada y el público lo acepta. ¿Por qué no aceptaría algo hecho por una inteligencia artificial si lo divierte y lo único que quiere es entretenerse?”, dice el productor.

Barceló parece sintonizar con parte de este planteo a partir de un ejemplo: “Hace poco leí la historia de un flaco, una especie de entrepreneur que quería invertir y contratar músicos y productores para armar una empresa con la intención de copar los cien primeros puestos de los charts. Quizás en poco tiempo empecemos a escuchar un montón de música nueva que puede tener hits sensacionales, que por ahí fueron creados por un tipo que puso a andar un agente autónomo y se convirtió en un magnate de la música”, proyecta.

Por el momento, Tweety encuentra el mayor rédito en las herramientas de IA que no están relacionadas de manera directa con la música, pero sí que pueden ser aplicadas a ese mundo, como la generación de artes de tapa para Twitin Records, su sello discográfico, y una extraña vuelta de tuerca que le encontró a ChatGPT. “Te ayuda bastante para crear los pitchs para Spotify [nota: la manera de hacerles llegar la información a los editores encargados de armar playlists]. Le cargás el tema y te ayuda a retocar información. Es un asistente piola, no es que lo haga solo. Lo tenés que ir tuneando para que te ayude, pero me ahorra tiempo y me inspira”, reconoce.

Con tanto material a disposición, la inteligencia artificial encierra también otro tipo de dilema: tener tantos mecanismos a disposición, de una forma tan amplia, ¿va en detrimento o no del nivel de creatividad de la obra?

“No deja de ser una herramienta, no creo que reemplace tanto como todo el mundo piensa. Sí para algunas cosas, desde mezclar, todo lo que es más técnico, todo lo que el sistema ‘piensa’. Si vos sabés qué darle de comer a la herramienta, la herramienta te va a hacer más feliz. Si no, te va a dar lo mismo que les da a todos”, vaticina Tweety, algo con lo que Woodgates coincide desde el otro lado del Atlántico. “Creo que va a liberar a los artistas para crear cosas más grandes y mejores. Si aprendés a usar una computadora y todo lo que puede aparecer en el proceso creativo, va a eliminar un montón de fricción. Podés tener la idea de una canción, interpretarla en una computadora y dejar que fluya, porque la IA va a eliminar todo el asunto técnico, como tener que saber operar plugins y cosas por el estilo. Vas a poder decirle de una manera mucho más sencilla y clara qué querés y qué estás tratando de alcanzar”, proyecta el guitarrista de Breezer.

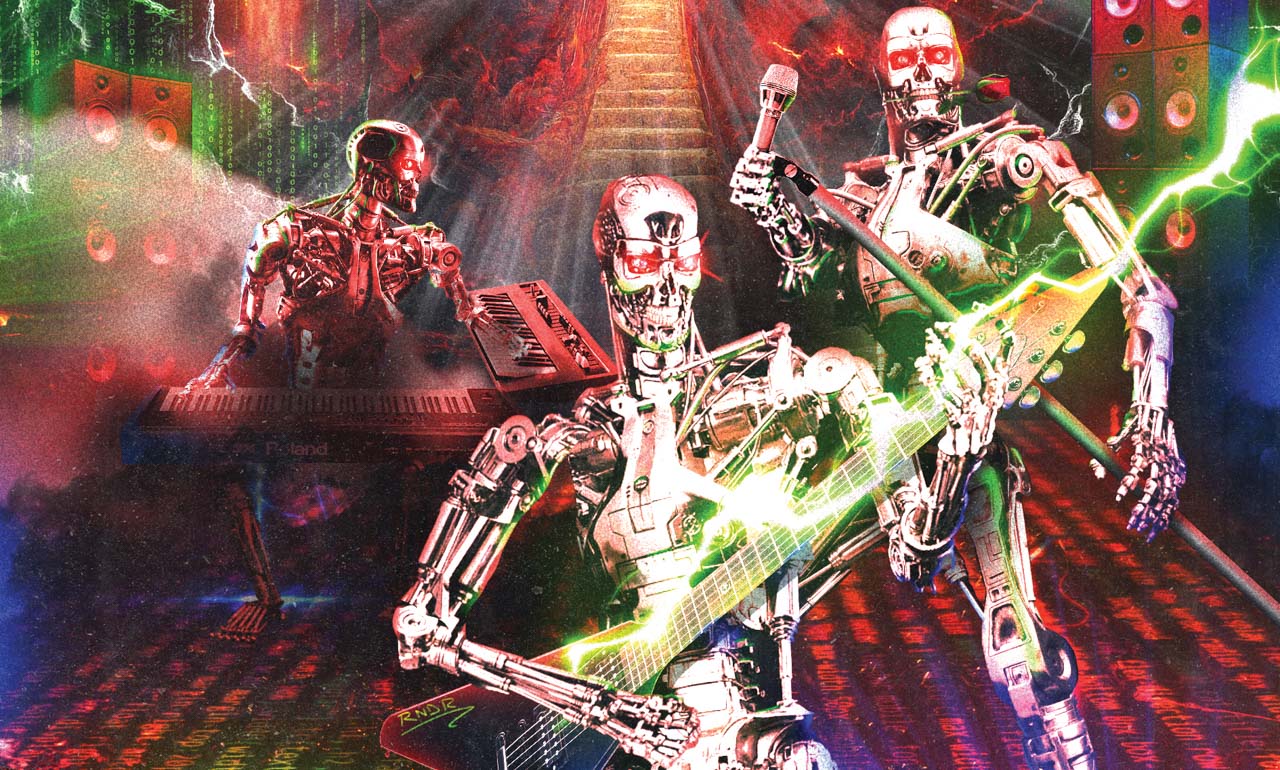

La velocidad con la que avanza todo lo relacionado al desarrollo informático de las inteligencias artificiales hace difícil establecer pronósticos, aunque para Barceló la creación de música en manos de agentes autónomos ya permite sacar algunas conclusiones. “En estos momentos, la noción de autor es de una liquidez absoluta, es vapor. Uno sí puede ser la persona que tuvo la voluntad detrás de eso y me parece que nos vamos a convertir en agentes de deseo y de voluntad que van a decir: ‘Quiero esto, esto, esto, esto, mejorámelo’, un par de iteraciones y listo. Me parece que hacia ahí va la creatividad”, dice sin temer que un descubrimiento tecnológico vaya a erradicar cualquier forma primigenia de arte. “La manera romántica de hacer música nunca va a desaparecer y nunca va a desaparecer tocar una guitarra eléctrica. Hasta ahora no cambió, por más que existan sintetizadores y tecnología MIDI. Además, es más lindo que ver un holograma”, reflexiona. De todos modos, la posibilidad de un Skynet cultural no deja de ser una posible nube gris que se posa sobre el universo de la música: “Hay que ver qué pasa con estas cosas, pero si se llega a generar una super inteligencia, olvidate. Vamos a hacer música para tocar con nuestros amigos y nuestras vidas van a ser otras”, remata.